Finie la ventilation des racks pour l’inférence des services IA. Refroidi par un fluide intégré, le cluster Vera Rubin de Nvidia soutient les systèmes d’agents les plus exigeants.

En pleine effervescence, les derniers processeurs multicœurs pour l’IA sont en train de redessiner les PC portables. Ils s’attaquent désormais aussi au design des datacenters où l’on pourra bientôt dire : le vent a tourné.

Bienvenue dans l’ère des superPods

La compétition entre hyperscalers (Alibaba Cloud, AWS, Azure, Google Cloud) encourage de nouveaux designs de fermes de serveurs conçues pour l’IA. Ces clusters évolutifs s’apprêtent à redessiner les centres de données intelligents pour aider les big tech, les sites de colocation et les entreprises à maximiser leur performances.

Comment ? Par le traitement automatisé de données et l’analyse de tendances en temps réel. nVidia veut saisir l’opportunité de ce marché et pousse régulièrement ses clusters dans leurs derniers retranchements.

L’IA fait son show à Las Vegas

Au CES de Las Vegas qui se termine aujourd’hui, une centaine de startups françaises confirment le potentiel d’innovations de l’IA tandis que les concepteurs locaux de microprocesseurs rivalisent d’annonces.

Conçus pour les PC destinés à l’IA et à l’e-sport, la gamme Serie 400 Ryzen AI d’AMD compte désormais sept membres, embarquant jusqu’à 16 cœurs CPU et 40 cœurs GPU. Pour sa part, Intel cible les robots et PC portables avec son Core Ultra Series 3 embarquant 12 cœurs GPU pour des terminaux autonomes jusqu’à 40 heures sans fil à la patte.

Mais le nerf de la guerre est ailleurs. Ceux qui maîtriseront les infrastructures de l’IA pourront capitaliser sur l’ensemble des données d’apprentissage et des réponses suggérées par l’IA.

Le ventilateur des fermes de serveurs haute densité disparaît au profit d’un liquid cooling appliqué aux processeurs.

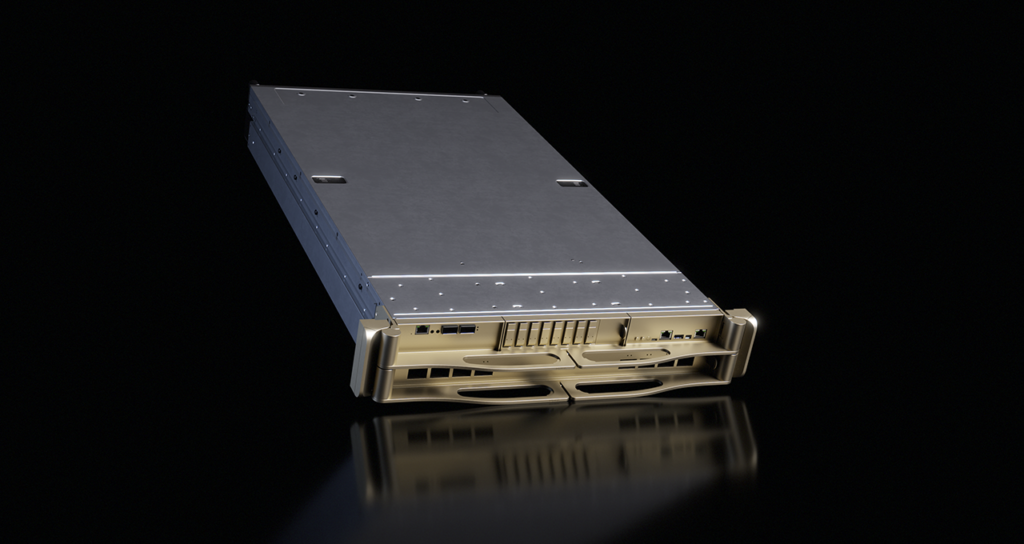

L’architecture Rubin de Nvidia succède à Blackwell en quadruplant ses performances (17,4 pétaflops en précision FP8). Elle escompte réduire de 10 fois le coût des jetons d’inférence par rapport à la génération Blackwell. De quoi reprendre l’ascendant sur les pods de calculs Google annoncés en mai dernier.

La dissipation de chaleur et la consommation électrique sont à l’avenant, au point d’exiger l’intégration de plaque froide et d’un circuit de refroidissement liquide dédié. Les serveurs de calcul voient ainsi disparaître leurs ventilateurs, et les pannes mécaniques associées. L’unité de traitements Nvidia Rubin retient exclusivement un refroidissement direct par fluide.

Le fluide caloporteur s’impose

Le marché mondial du refroidissement liquide des centres de données connaît une forte croissance. Une étude récente du cabinet Dell’Oro l’évalue à près de 7 milliards de dollars d’ici à 2029.

« Le refroidissement liquide a franchi un seuil critique, », observe le directeur de recherches Alex Cordovil, soulignant que le refroidissement liquide direct monophasé domine désormais les déploiements d’IA à grande échelle, car les charges de travail de l’IA poussent le refroidissement par air au-delà des limites pratiques.

Hier encore une option d’efficacité, le liquid cooling devient une exigence fondamentale pour l’infrastructure IA de nouvelle génération, notamment sous l’impulsion de l’augmentation rapide des niveaux de puissance des GPU.

« La course aux IA dans le cloud impose une réduction drastique des coûts pour des performances sans cesse plus élevées. Or, l’un des derniers gisements d’économie du datacenter réside dans ses circuits de refroidissement actuels, » confirme François Tournesac, Datacenter Decarbonisation Project Lead et Manager d’Impleon, qui promeut la boucle unique de refroidissement par fluide caloporteur.

Le vent à tourné

Pour l’inférence d’IA à grande échelle, Google et Meta retiennent désormais une combinaison d’accélérateurs AMD, en alternative à l’architecture NVidia. Les fermes de GPU et de CPU sont glissées dans un rack ORW (Open Rack Wide de l’OCP). Ce châssis matériel ouvert double-largeur accepte une charge utile de 3,5 tonnes. Il est optimisé en puissance (700 kW+), en refroidissement liquide et en maintenance. Les deux géants confirment ainsi que les systèmes d’IA modernes exigent une infrastructure haute densité fiable, disponible, très bien refroidie.

Un autre acteur du centre de données a bien senti le vent tourner. En prévision des premiers racks de 1 MW qui seront produits d’ici à 2028, Eaton a racheté la division Boyd Thermal de Boyd Corporation, moyennant 9,5 milliards de dollars en novembre dernier. Boyd Thermal prévoit un chiffre d’affaires de 1,7 milliard de dollars cette année, dont 88% devraient être issus du refroidissement liquide pour les centres de données.