Pourquoi s’en tenir aux abonnements de services et de modèles d’IA ? Le géant californien veut orchestrer toute l’infrastructure nécessaire, quitte à repousser les limites de puissance, d’efficacité énergétique et de cybersécurité des datacenters. Sa transition vers une IA durable passe par la mutualisation d’innovations et la co-conception au sein de l’Open Compute Project.

L’offensive de Google dans l’IA chahute les repères de l’industrie du datacenter. Lors de son événement Google Cloud Next 2025, le géant californien a révélé une infrastructure propulsant l’IA à de nouveaux niveaux. Mais le modèle gratuit appartient au passé. Les tarifs d’abonnement évoluent dorénavant de 20$ à 250$ par mois pour le service VIP baptisé « AI Ultra ».

Pour quel retour sur investissement ? L’entreprise utilisatrice pourra fidéliser ses clients et leur offrir une expérience de navigation sans pareil, nous dit-on. En particulier, « l’IA agentique procure des interactions plus efficaces, une meilleure productivité, et des connaissances approfondies susceptibles d’améliorer la satisfaction des clients, » observe Antoine Imbert, VP de Capgemini en charge des partenariats avec les hyperscalers.

Un seul pod de calcul IA, équipé de la dernière génération de puces Ironwood (TPU v7), délivrerait plus de 42 exaflops de puissance, soit 24 fois la performance du plus rapide des superordinateurs actuels. Pour mettre ce chiffre en perspective, c’est comme si chaque habitant de la planète disposait d’un PC puissant, tous connectés et synchronisés pour mener une même tâche.

Cette montée en puissance s’accompagne d’une efficacité énergétique multipliée par 29 par rapport à la première génération de TPU. De quoi répondre à l’explosion des requêtes IA tout en contenant leur consommation électrique. Une aubaine tandis qu’AI Overviews – l’avenir du moteur de recherche offrant une expérience générative et de nouveaux revenus publicitaires – est déployé vers plus de 200 pays en 40 langues, mais toujours pas en France.

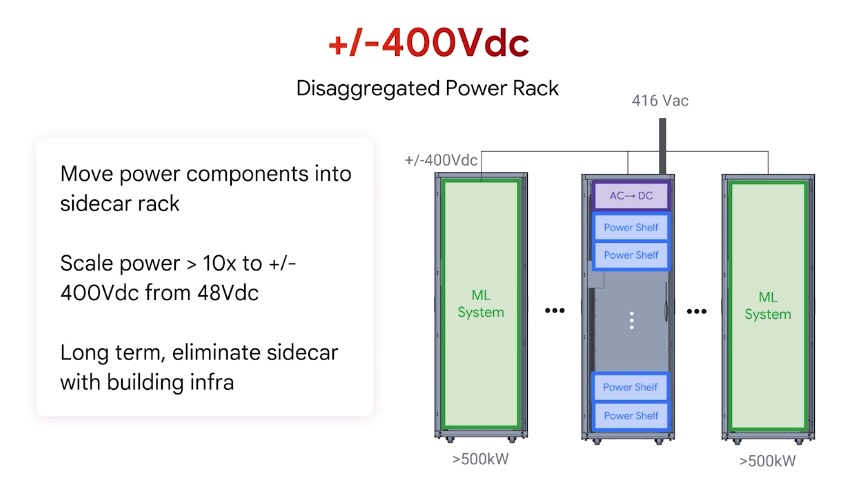

Tandis qu’un rack actuel plafonne à quelques kilowatts, le rack IA de Google dépasse déjà les 100 kilowatts ; ce sera cinq fois plus à l’horizon 2030. Pour refroidir ce monstre, Google déploie à grande échelle le refroidissement liquide, une technologie réservée hier aux mainframes puis aux supercalculateurs de recherche.

L’innovation ne s’arrête pas là. Google a repensé l’alimentation électrique de ses datacenters, passant de 48 volts à une architecture inspirée des véhicules électriques avec du +400/-400 volts DC. Résultat : une efficacité accrue, moins de pertes et la possibilité d’alimenter des racks toujours plus denses, tout en réduisant l’empreinte carbone de l’exploitation des services IA.

L’enjeu environnemental reste central

En dépit des orientations de l’administration Trump 2.0, Google vise toujours une neutralité carbone d’ici à 2030 et poursuit ses initiatives pour verdir ses centres de données : béton bas carbone, remplacement des groupes électrogènes diesel, optimisation du refroidissement et de l’alimentation. La transition vers une IA durable passe par la mutualisation des innovations et la collaboration ouverte avec l’ensemble de l’écosystème, notamment avec l’Open Compute Project dont le dernier sommet s’est tenu fin avril à Dublin (voir les vidéos de l’OCP EMEA Summit).

« En conséquence des récents événements géopolitiques, les tentatives passées de Google, AWS et Microsoft d’exécuter les charges de travail de recherche et développement françaises sur le cloud s’estompent. Il est temps maintenant pour les nouveaux acteurs des centres de données tels qu’Opcore, Phocea, Thésée, Voltekko de fournir une approche de colocation en ligne avec le centre de données construit pour Mistral par Eclairion. Les fabricants de serveurs américains comme DELL promeuvent désormais les serveurs OCP. C’est un premier pas vers l’Open Hardware. Ces solutions de haute densité et de calcul intensif seront intégrées dans la norme Open Rack v3 de l’OCP. L’événement Computex 2025 de Taipei vient de démontrer que les Taïwanais sont prêts à concevoir de nouveaux datacenters d’IA autour de solutions telles que xAI-Colosus, le plus grand superCluster actuel, » observe François Tournesac, CEO d’Impleon et responsable régional OCP France.

Stockage et sécurité au diapason

Côté stockage, Google présente Hyperdisk Exapools, présenté comme le stockage en mode bloc aux performances et capacité par cluster les plus élevées du moment. Anywhere Cache, pour sa part, rapproche les données des accélérateurs pour réduire les délais de latence de plus de deux tiers (70% selon les prévisions de Google).

La sécurité n’est pas en reste : Google a dévoilé Unified Security, une plateforme qui centralise la détection, la réponse et la visibilité de toute la surface d’attaque numérique, le tout renforcé par des agents Gemini capables d’automatiser l’analyse des menaces et la gestion des alertes. Cette approche préventive s’apparente à un système immunitaire capable de réagir en temps réel à toute tentative d’intrusion.

« L’IA n’est plus seulement un outil ; elle s’apparente à un réseau d’organes vitaux pour l’innovation de nos clients, » martellent les dirigeants de Google cherchant à séduire les actionnaires.

Spammers et hackers sans frontière linguistique

Les derniers modèles Gemini 2.5, prétendûment capables de raisonner, illustrent cette évolution vers des IA plus fines et nuancées, produisant de meilleurs résultats. La génération de codes informatiques, l’analyse d’images médicales et la création sur mesure de modèles 3D et d’animations devraient en profiter. La traduction en temps réel s’immisce dans les échanges visio Google Meet, l’IA simulant à présent votre propre voix dans la langue de vos locuteurs… Une fonctionnalité qui ne manquera pas d’être détournée, tôt ou tard, par des spammers et hackers sans frontière.

Les plateformes telles Vertex AI et les réseaux privés étendus (Cloud WAN) gagnent aussi en performances (+40%) à moindre coût. Les entreprises optant pour cette infrastructure pourront-elles accélérer leur innovation et conquérir de nouveaux marchés à leur tour ? C’est bien la promesse répétée par Google et ses partenaires, du Convention Center de Las Vegas le mois dernier au Cloud Summit France à l’Accor Arena de Paris Bercy cette semaine.

👉 Sur ce thème, lire la synthèse du débat Green IT du dernier forum IA.Cloud de Paris Expo, avec trois experts du sujet : L’IA impose davantage de-sobriété numérique.

👉 L’IA responsable et durable est le thème central de OW2con’25 les 17-18 juin chez Orange Gardens à Châtillon. Un rendez-vous à ne pas manquer, gratuit pour les professionnels IT, avec 40 intervenants internationaux, un débat ouvert et des espaces de réseautage conviviaux.